Een nieuw machine-learningmodel stelt robots in staat om interacties tussen verschillende voorwerpen te begrijpen. Dit is handig voor industriële robots die ingewikkelde, meerstaps manipulatietaken moeten uitvoeren, zoals het stapelen van artikelen in een magazijn of het samenstellen van apparaten.

Wanneer mensen naar een scène kijken, zien ze objecten en de relaties daartussen. Boven op uw bureau bevindt zich mogelijk een laptop die links van een telefoon zit, die voor een computerscherm staat.

Veel deep learning-modellen hebben moeite om de wereld op deze manier te zien, omdat ze de verstrengelde relaties tussen individuele objecten niet begrijpen. Zonder kennis van deze relaties zou een robot die is ontworpen om iemand in een keuken te helpen, moeite hebben met het volgen van een commando als "pak de spatel aan de linkerkant van het fornuis en plaats deze op de snijplank."

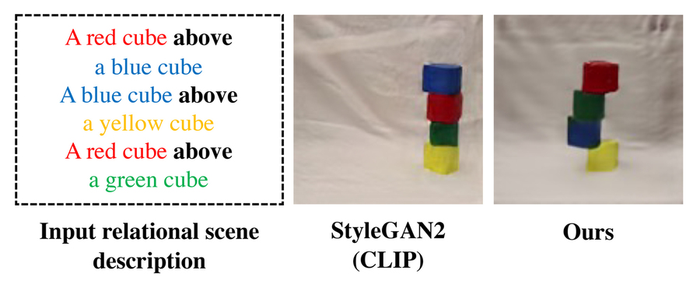

In een poging om dit probleem op te lossen, hebben MIT-onderzoekers een model ontwikkeld dat de onderliggende relaties tussen objecten in een scène begrijpt. Hun model geeft individuele relaties één voor één weer en combineert deze representaties om de algehele scène te beschrijven. Hierdoor kan het model nauwkeurigere afbeeldingen genereren uit tekstbeschrijvingen, zelfs wanneer de scène meerdere objecten bevat die in verschillende relaties met elkaar zijn gerangschikt.

"Als ik naar een tafel kijk, kan ik niet zeggen dat er een object op de XYZ-locatie staat. Zo werkt onze geest niet. In onze gedachten, wanneer we een scène begrijpen, begrijpen we het echt op basis van de relaties tussen de objecten. We denken dat we door een systeem te bouwen dat de relaties tussen objecten kan begrijpen, dat systeem kunnen gebruiken om onze omgevingen effectiever te manipuleren en te veranderen", zegt Yilun Du van het Computer Science and Artificial Intelligence Laboratory (CSail).

Eén relatie per keer

Het raamwerk dat de onderzoekers ontwikkelden, kan een afbeelding van een scène genereren op basis van een tekstbeschrijving van objecten en hun relaties, zoals ‘Een houten tafel links van een blauwe kruk. Een rode bank rechts van een blauwe kruk.’

Hun systeem zou deze zinnen opsplitsen in twee kleinere stukken die elke individuele relatie beschrijven (‘een houten tafel links van een blauwe kruk’ en ‘een rode bank rechts van een blauwe kruk’), en vervolgens elk onderdeel afzonderlijk modelleren. Die stukken worden vervolgens gecombineerd via een optimalisatieproces dat een beeld van de scène genereert.

De onderzoekers gebruikten een machine learning-techniek, op energie gebaseerde modellen genaamd, om de individuele objectrelaties in een scènebeschrijving weer te geven. Deze techniek stelt hen in staat om één op energie gebaseerd model te gebruiken om elke relationele beschrijving te coderen, en ze vervolgens samen te stellen op een manier die alle objecten en relaties afleidt.

Door de zinnen voor elke relatie op te splitsen in kortere stukjes, kan het systeem ze op verschillende manieren opnieuw combineren, zodat het zich beter kan aanpassen aan scènebeschrijvingen die het nog niet eerder heeft gezien, zegt mede-onderzoeker Shuang Li.

"Andere systemen zouden alle relaties holistisch bekijken en de afbeelding in één keer uit de beschrijving genereren. Dergelijke benaderingen mislukken echter wanneer we beschrijvingen hebben die buiten de distributie vallen, zoals beschrijvingen met meer relaties, omdat deze modellen niet echt één opname kunnen aanpassen om afbeeldingen te genereren die meer relaties bevatten. Maar omdat we deze afzonderlijke, kleinere modellen samen samenstellen, kunnen we een groter aantal relaties modelleren en ons aanpassen aan nieuwe combinaties", zegt Du.

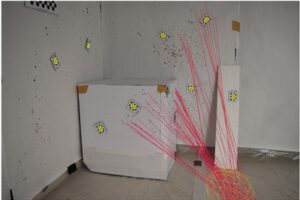

Het systeem werkt ook omgekeerd: bij een afbeelding kan het tekstbeschrijvingen vinden die overeenkomen met de relaties tussen objecten in de scène. Bovendien kan hun model worden gebruikt om een afbeelding te bewerken door de objecten in de scène opnieuw te rangschikken, zodat ze overeenkomen met een nieuwe beschrijving.