Een van de obstakels bij de adoptie van AI is dat het niet kan verklaren waarop een voorspelling is gebaseerd. De machine learning-systemen nemen beslissingen waarvan de onderliggende redenering voor de gebruiker niet begrijpelijk zijn. Meike Nauta van de Universiteit Twente heeft een model gemaakt om dit ‘blackbox-karakter’ van deep learning-modellen aan te pakken.

Een paper over ProtoTree is geaccepteerd op de CVPR2021, de jaarlijkse conferentie over computervisie en patroonherkenning (19 t/m 25 juni).

Algoritmes zijn al in staat om nauwkeurige voorspellingen te doen, zoals medische diagnoses, maar ze kunnen niet verklaren hoe ze tot een dergelijke voorspelling zijn gekomen. De afgelopen jaren is er veel aandacht geweest voor het uitlegbare AI-veld. "Voor veel toepassingen is het belangrijk om te weten of het model de juiste redenering gebruikt om tot een bepaalde voorspelling te komen. Met verklaarbare AI kunnen vragen als ‘wat heeft het model geleerd?’ en ‘hoe komt het model tot zo’n voorspelling?’ worden beantwoord", zegt Nauta.

Eerder uitlegbaar AI-onderzoek maakte veelal gebruik van post-hoc verklaarbaarheidsmethoden, waarbij het model pas na training van het model wordt geïnterpreteerd. Een relatief nieuwe richting, waar nog weinig onderzoek naar is gedaan, is ‘intrinsically interpretable machine learning’. Het grote verschil hierin is dat de uitlegbaarheid al in het model zelf is verwerkt: interpretability by design. Hier is Nauta mee aan de slag gegaan – en met succes. Ze ontwikkelde een model genaamd Neural Prototype Tree, kortweg ProtoTree, voor interpreteerbare beeldclassificatie.

Hoe werkt het?

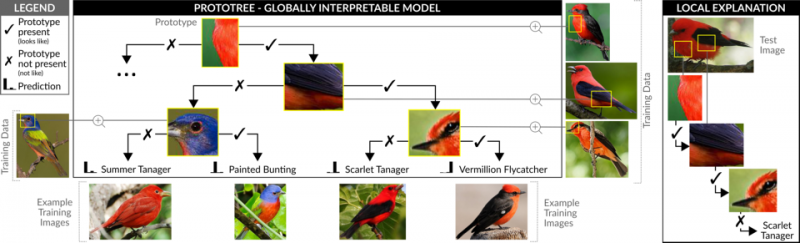

"De redenering van het model is vergelijkbaar met het spel ‘Wie ben ik?’, waarbij je bijvoorbeeld vraagt of de persoon rood haar heeft. Je krijgt een ja of nee antwoord, waarna je de volgende vraag stelt", zegt Nauta. Het ProtoTree-model werkt volgens hetzelfde principe. Het model is getraind op een dataset bestaande uit afbeeldingen van 200 verschillende vogelsoorten. Wanneer het model wordt blootgesteld aan een input image, zoekt het model naar overeenkomende fysieke kenmerken van een soort vogel – bijvoorbeeld bij de aanwezigheid van een rode borst, een zwarte vleugel en een zwarte streep bij het oog, wordt een Rode Tiran herkent.

Volgens co-auteur Christin Seifer is dit proces vergelijkbaar met het aanleren van nieuwe dingen aan een kind. "Je vertelt een kind bijvoorbeeld dat het dier op de foto een hond is, maar je vertelt het kind niet precies welke fysieke eigenschappen een hond heeft. Het kind leert simpelweg andere honden herkennen aan de hand van die ene foto van een hond", aldus Seifert.

Voordelen

"Een van de grootste voordelen is dat het model stapsgewijs kan redeneren, waardoor je kunt volgen hoe het model tot een bepaalde voorspelling komt", zegt Nauta. "Bovendien laat het ook zien waar het model zijn keuzes precies op heeft gebaseerd, zodat verkeerd geleerde associaties in het model kunnen worden ontdekt". ProtoTree onthulde bijvoorbeeld de vooringenomenheid dat het model leerde om een type watervogel te onderscheiden van een zangvogel door te kijken naar de aanwezigheid van boombladeren. Door de mogelijke vooroordelen van het model te laten zien, is discriminatie door machine learning-algoritmen aangepakt.

Wat is hier nieuw aan?

De aanpak levert een beslisboom op, wat niet nieuw is – beslisboom-learning bestaat al tientallen jaren. Echter worden beslisbomen zelden gebruikt voor beeldclassificatie omdat standaard beslisbomen niet goed met afbeeldingen kunnen omgaan. "De nieuwigheid hier is dat de beslispunten bestaan uit kleine afbeeldingen die in één oogopslag geïnterpreteerd kunnen worden en dus betekenisvol zijn voor de mens. Deze zogeheten ‘prototypes’ zijn bovendien automatisch ontdekt uit alleen de voorbeeldbeeldgegevens", zegt Maurice van Keule van de Universiteit Twente. "Het magische hieraan is dat er in dit proces geen menselijk deskundig begrip nodig is, alleen enkele voorbeeldafbeeldingen. Stel je voor: je weet niets van vogelsoorten, je krijgt allemaal foto’s van vogels met de bijbehorende namen, waarna jij vervolgens een boek moet gaan schrijven over het categoriseren van vogels."

Ter vergelijking: bij black box machine learning is de computer een leerling die leert een taak zelf uit te voeren. Het leert dus vogels te classificeren door de naam van de vogel te ‘voorspellen’. Bij intrinsically interpretable machine learning wordt de computer echter een leraar die mensen kan onderwijzen, zonder dat deze zelf enige opleiding heeft genoten.