Intuïtiviteit is moeilijk te leren, vooral aan een machine. Om dit te verbeteren, bedacht een team van MIT’s Computer Science and Artificial Intelligence Laboratory (CSAIL) een methode die ons dichter bij een meer naadloze samenwerking tussen mens en robot brengt. Conduct-A-Bot gebruikt menselijke spiersignalen om, via draagbare sensoren, de beweging van een robot te sturen.

"We stellen ons een wereld voor waarin machines mensen helpen met cognitief en fysiek werk en om dat te doen, passen ze zich aan mensen aan in plaats van andersom", zegt Daniela Rus, directeur van CSAIL en co-auteur van een paper over het systeem.

Om naadloos teamwerk tussen mens en machine mogelijk te maken, worden elektromyografische en bewegingssensoren gedragen op de biceps, triceps en onderarmen om spiersignalen en beweging te meten. Algoritmen verwerken de signalen om gebaren in realtime te detecteren, zonder offline kalibratie of training per gebruiker. Het systeem gebruikt slechts twee of drie draagbare sensoren en niets in de omgeving – waardoor de drempel voor gebruik wordt verkleind.

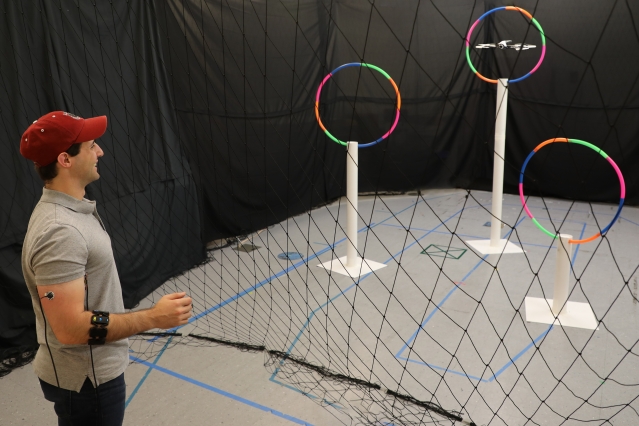

Conduct-A-Bot kan worden gebruikt voor verschillende scenario’s, waaronder het navigeren door menu’s op elektronische apparaten of het toezicht houden op autonome robots. Voor het onderzoek gebruikte het team een Parrot Bebop 2-drone, hoewel elke commerciële drone kon worden gebruikt.

Door acties te detecteren, zoals rotatiegebaren, het ballen van de vuisten, het spannen van armen en het activeren van onderarmen, kan Conduct-A-Bot de drone naar links, rechts, omhoog, omlaag en vooruit bewegen en hem laten draaien en stoppen.

Tijdens tests waarbij hij door hoepels moest vliegen, reageerde de drone correct op 82 procent van 1.500 menselijke gebaren toen hij op afstand werd bestuurd. Het systeem identificeerde ook ongeveer 94 procent van de gebarende gebaren correct wanneer hij niet werd bestuurd.

"Door onze gebaren te begrijpen, kunnen robots meer non-verbale aanwijzingen interpreteren die we van nature in het dagelijks leven gebruiken", zegt hoofdauteur Joseph DelPreto. "Dit type systeem kan helpen om de interactie met een robot meer te laten lijken op de interactie met een andere persoon, en het voor iemand gemakkelijker te maken om robots te gaan gebruiken zonder eerdere ervaring of externe sensoren."

Dit type systeem kan uiteindelijk gericht zijn op een reeks toepassingen voor samenwerking tussen mens en robot, waaronder verkenning op afstand, ondersteunende persoonlijke robots of productietaken zoals het afleveren van objecten of het tillen van materialen.

De tools passen ook in een samenleving waar mensen afstand van elkaar houden en kunnen mogelijk een gebied van toekomstig contactloos werk openen. Je kunt je bijvoorbeeld voorstellen dat machines door mensen worden bestuurd om een ziekenhuiskamer veilig schoon te maken of medicijnen af te geven, terwijl wij mensen op veilige afstand blijven.

Spiersignalen kunnen bovendien informatie geven over moeilijk te observeren toestanden, zoals gewrichtsstijfheid of vermoeidheid. Als je bijvoorbeeld een video bekijkt van iemand die een grote doos vasthoudt, kan het moeilijk zijn om te raden hoeveel inspanning of kracht er nodig was – en een machine zou het ook moeilijk vinden om dat te zien. Het gebruik van spiersensoren biedt mogelijkheden om niet alleen beweging in te schatten, maar ook de kracht en het koppel die nodig zijn om dat fysieke traject uit te voeren.

Voor de gebarenwoordenschat die momenteel wordt gebruikt om de robot te besturen, werden de bewegingen als volgt gedetecteerd:

- verstijving van de bovenarm om de robot te stoppen (vergelijkbaar met kort ineenkrimpen wanneer je iets verkeerd ziet zien): biceps en triceps spier signalen

- de hand naar links / rechts en omhoog / omlaag zwaaien om de robot zijwaarts of verticaal te bewegen: signalen van de onderarmspieren (waarbij de onderarmversnellingsmeter de handoriëntatie aangeeft);

- vuist balde om de robot naar voren te bewegen: signalen van de onderarmspieren; en

- rechtsom / linksom draaien om de robot te draaien: onderarmgyroscoop.

Machine learning-classificaties hebben de gebaren gedetecteerd met behulp van de draagbare sensoren. Ongecontroleerde classificatoren verwerkten de spier- en bewegingsgegevens en clusteerden deze in realtime om te leren hoe gebaren te scheiden van andere bewegingen. Een neuraal netwerk voorspelde ook flexie of extensie van de pols door signalen van de onderarmspieren.

Het systeem kalibreert zichzelf in wezen op de signalen van elke persoon terwijl ze gebaren maken die de robot besturen, waardoor het voor tijdelijke gebruikers sneller en gemakkelijker wordt om interactie met robots aan te gaan.

In de toekomst hoopt het team de tests uit te breiden met meer voorbeelden. En terwijl de bewegingen voor Conduct-A-Bot veelvoorkomende gebaren voor robotbewegingen omvatten, willen de onderzoekers de ‘woordenschat’ uitbreiden met meer continue of door de gebruiker gedefinieerde gebaren.

"Uiteindelijk hopen we dat de robots van deze interacties leren om de taken beter te begrijpen en meer voorspellende hulp te bieden of hun autonomie te vergroten. Dit systeem komt een stap dichterbij om ons naadloos met robots te laten werken, zodat ze effectievere en intelligentere tools kunnen worden voor alledaagse taken", zegt DelPreto.